在虚拟现实领域,快速创建定制虚拟人物并实现与其互动是一个普遍的应用场景。然而,以往的方法在快速重建高保真3D数字人体和实时渲染之间往往难以平衡。在这项研究中,提出了Human101,这是一个新颖的框架,能够在仅一视角视频中以100秒的训练时间生成高保真的动态3D人体模型,并以100+ FPS的速度进行渲染。

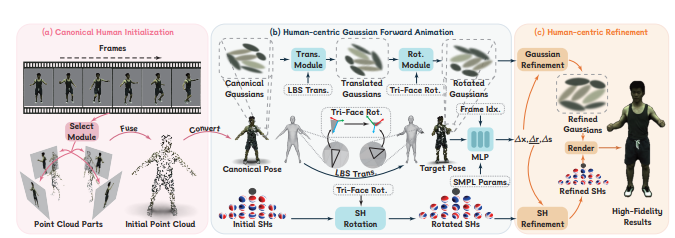

与以往的基于NeRF的管道不同,Human101巧妙地应用了人体中心的前向高斯动画方法,通过调整3D高斯的参数来提高渲染速度。实验证明,该方法在每秒帧数上取得了显著的增长,同时提供可比较或更高的渲染质量。

为解决传统方法中存在的渲染速度慢和收敛速度慢的问题,Human101采用了更实用和改进的方法。首先,采用光栅化渲染管线,取代传统的体素渲染方法,以提高渲染速度。其次,选择了一种更易于优化的表示方法,即3D高斯,从而将优化时间降低到几分钟。

Human101特色包括:

- 创新地采用3D高斯散点技术,为详细和准确的人体建模提供了高效的明确表示。引入了规范人体初始化方法,显著提高了模型的收敛速度和视觉细节表达。

- 提出了一种包括人体中心的前向高斯动画和样本点+反向脱皮体渲染的变形方法,与传统的耗时的逆向脱皮框架不同,实现了实时快速重建和渲染动态人体。

- 在推断阶段,相较于先前的神经人体表示,实现了渲染速度的约10.8倍提升(对于512×512分辨率的图像为100+ FPS),同时确保了可比较或更高的渲染质量和更高的图像分辨率。

Human101通过引入创新的技术和实用的方法,成功地解决了单视角视频中快速建模和实时渲染之间的矛盾,为实时交互应用和沉浸式虚拟现实体验提供了可行的解决方案。

论文网址:https://arxiv.org/pdf/2312.15258.pdf

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表本站立场。