苹果近日发布的一篇语言模型相关的论文,预示了未来的Siri可能拥有读懂屏幕的能力,这意味着苹果终端设备更智能的交互能力。

4月2日消息,苹果研究团队发表了一篇名为《ReALM: Reference Resolution As Language Modeling》的论文,主题在于解决非对话实体(non-conversational entities)中的指代消解(Reference resolution)问题。

文章摘要指出,虽然大语言模型被证明在许多任务处理中表现强大,但在屏幕实体、后台实体等非对话实体中的指代理解能力,还没有得到充分的开发利用。

其中,“对话实体”指的是在对话过程中出现的具体对象或概念,可以是任何提及并被讨论的事物,例如人名、地点、事件、产品、观点等;“屏幕实体”指的是用户在电子设备屏幕上可以看到的各种元素,例如文本、图标、按钮、图片、视频等;“后台实体”通常指的是在电子设备的操作系统或应用程序中运行的、对用户不可见的进程和服务。

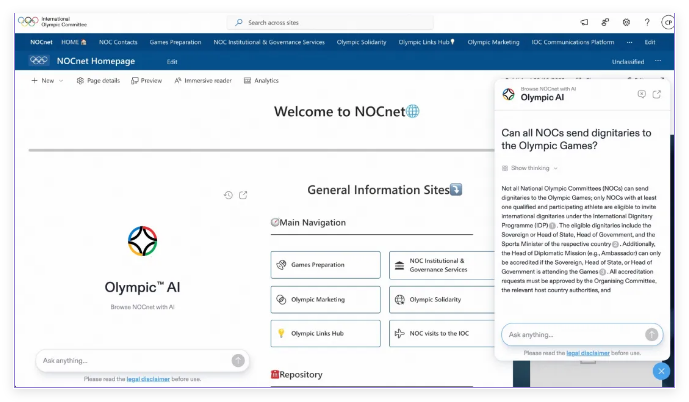

这篇文章主要展示了,如何利用大语言模型建立能够解析各种类型指代(尤其是非对话实体)的高效系统。团队的方法是将其转化为一个纯粹的语言建模问题,具体而言,ReALM(该模型的名称)通过已经解析的实体及其位置来重建屏幕,生成一个可视觉识别的文本,并通过对屏幕中的实体进行标注,使其具备出现所在位置的上下文,这就使得系统能够理解用户在屏幕上看到的内容。

苹果研究团队在结果中展示了不同模型在各种数据集上的准确性结果,包括ReALM-80M/250M/1B/3B四种参数大小模型,并与GPT-3.5和GPT-4都进行了对比。数据显示,这种针对指代消解进行微调的语言模型,在多数表现上优于GPT-4。

最新发表的这篇论文,表明了苹果的努力方向之一就在于加强Siri以及其他产品对于实体及其上下文的感知和解析能力,这可能让苹果在硬件设备的智能交互水平上相较竞争者占据优势。不过研究人员也明确指出,依靠屏幕的自动解析存在局限性,因为在更复杂的视觉指代解析中,如区分多个图像,可能需要结合计算机视觉和多模态技术。

在AI大模型、生成式AI等AI技术上,苹果虽然入局稍晚,但动作高效且成果颇为明显,在AI上的投入方向也越来越明朗。本月初,苹果已经发表了一篇论文,公布自己研发的MM1多态大语言模型(Multimodal LLM),最大拥有300亿参数(并不算一个很高的数值),但尚未公测或公布上线时间。

公司似乎也正在筹备让Siri接入大模型。据极客公园报道,今年1月,有开发者在iOS 17.4的开发者预览版Beta中发现了与大模型相关的技术代码。这些代码表明,苹果正在开发一个由大模型支持的新版本Siri。

在苹果之前,其全球范围内最大竞争对手三星已经在AI手机上抢跑,在最新旗舰系列中打出Galaxy AI战略,从翻译、拍照、修图、搜索等方面全面加入AI能力,并在中国市场也迅速找到百度、WPS、美图等公司完成本土化落地。

而从去年下半年开始,国内手机厂商的AI布局声量已经渐起。去年8月,华为HarmonyOS 4全面接入盘古大模型;10月,小米自研AI大模型“MiLM-6B”接入澎湃OS;11月,vivo发布自研“蓝心大模型”,OPPO在ColorOS 14引入“安第斯大模型”。今年1月,荣耀也发布自研70亿参数端侧AI大模型“魔法大模型”。

事实上,现有智能手机的AI功能主要围绕应用层,效果在于提升个别功能的使用效率,但除了实时通话翻译这样的场景属于刚需的一种,其他方向的效果还没有足够惊艳。所以如果是要强大到撬动用户的换机诉求,赛道中还没有出现这样的AI手机选手。

苹果这篇论文留出的想象空间在于,如果Siri对于屏幕实体有了足够强的理解能力,那用户可以发起的智能交互范畴就会明显扩大。例如,也许未来用户可以通过语音让Siri在某个外卖平台上进入某家店铺订一份餐——这个交互步骤的确是基于现状的大幅度简化。

但这会是用户想要的新iPhone吗?或许苹果也没有答案。市场可以期待的是,在苹果今年的WWDC(全球开发者大会)上,它会给这场挑战起一个什么样的开头,使得观众不会唏嘘它迟到如此之久。

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表本站立场。