不需要预训练就能获得新的基础模型?这是Sakana.ai最新发布的技术,他们使用“进化模型合并”算法(Evolutionary Model Merge),开发具有特定能力的基础模型,免除了从头预训练基础模型的巨大计算成本。

Sakana.ai由前谷歌研究人员David Ha、Llion Jones (Transformer论文作者之一)联合创立,目前它已获得Lux Capital领投,Khosla Ventures 参与的3000万美元种子轮融资,日本的NTT集团、KDDI CVC和索尼集团;个人天使投资人Jeff Dean、Clem Delangue(Hugging Face创始人)和Alex Wang(Scale AI创始人),以及包括500 Global、Miyako Capital、Basis Set Ventures、JAFCO、July Fund、Geodesic Capital和Learn Capital在内的其他知名全球公司也参与了投资。

Sakana.ai能将开源社区的模型博采众长,使用创新方法低成本生成新的模型,对于AI开源生态的繁荣,对于中小企业AI创业,都有积极的意义。

Transformer论文作者用创新方法改变AI模型范式

Transformer论文的作者们几乎都已创业,而且创业的方向各不相同,有情感聊天机器人,生物医药AI和企业级AI Agent等。

David Ha、Llion Jones (Transformer论文作者之一)联合创立的Sakana.ai则十分有特点,它致力于基础模型,却不是从头按照传统方法预训练基础模型。

现在Scaling Law是AI模型训练的主流思想:模型越大越好,数据越多越好。但这同时就代表着巨量的算力成本,而Sakana.ai则反其道而行之,他们的方法几乎不需要花费算力成本,就能获得高性能的模型。

除了David Ha、Llion Jones,Sakana.ai的核心团队主要由来自Google Brain, Google DeepMind,Stability AI等头部的AI研究机构,其中包括多位亚裔,他们致力于建立一个世界级的 AI 实验室。

Sakana的名字来源于日语单词さかな(sa-ka-na),意为鱼。Sakana.ai希望在研究中利用来自自然的想法,如进化和集体智能,这也充满了东方智慧。

Lux Capital的Managing Partner Josh Wolfe表示:“在AI领域,每个人都在追逐昨天的Transformer架构,并试图推动Scaling Law的边界。我们在Sakana.ai团队正在开发的受进化和复杂适应系统启发的新基础模型中找到新的目标。”

Khosla Ventures的创始人Vinod Khosla则表示:“大多数国家都希望拥有自己的本土基础模型,这既是出于国家安全的考虑,也是为了更好地与地区方言、文化和价值观进行互动。此外,人工智能人才在全球范围内分布,而且对于像Sakana.ai这样的世界级项目,部署这些人才的需求并不缺乏。”

无需预训练,用“进化模型合并”方法生成新的高性能模型

Sakana.ai的核心研究焦点在于应用受自然启发的思想,如进化和集体智能,以创建新的基础模型。

对于集体智能,Sakana.ai认为人工智能将遵循与人类的集体智能类似的集体路径,未来的AI不会由一个单一的、巨大的、全知的AI系统组成(他们需要巨大的能源来训练、运行和维护),而是由大量小型AI系统组成,每个系统都有自己的利基和专长,相互作用,开发新的AI系统以填补特定的利基。

目前他们看到的是开源AI生态系统中的趋势,开源基础模型容易被扩展和微调成数百个不同的方向,以产生在各自利基中表现出色的新模型。Open LLM排行榜上表现最好的模型不再是原始的开源基础模型,如LLaMA或Mistral,而是现有模型的微调或合并。

对于进化,Sakana.ai发布了《模型合并配方的进化与优化》报告,进化模型合并是一种通用方法,使用进化技术有效地发现将不同模型从巨量的开源模型中以多样化能力组合起来的最佳方式。目前,Hugging Face拥有超过500k个模型,涵盖数十种不同的模态,原则上可以组合成具有新能力的新模型。

具体来说,进化模型合并结合了两种不同的方法:(1)在数据流空间(层)中合并模型,和(2)在参数空间(权重)中合并模型。

在数据流空间(层)中合并模型

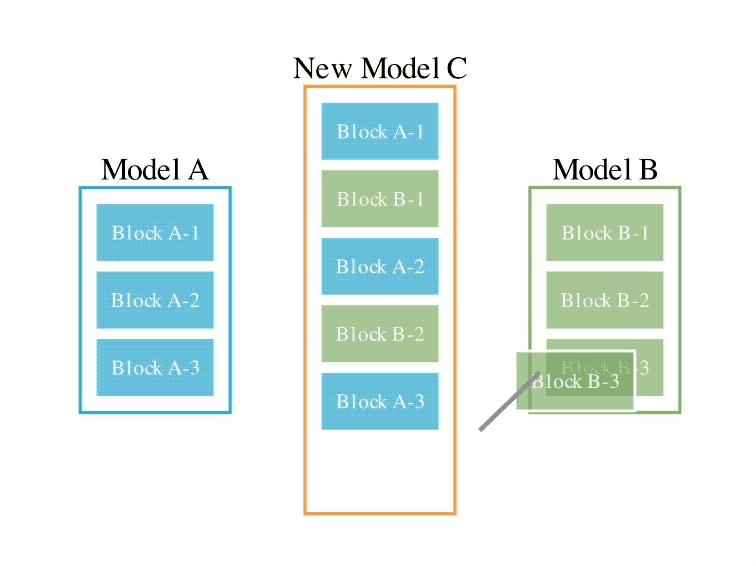

第一种方法是使用进化来发现不同模型的层的最佳组合,以生成一个新模型。

在模型合并社区中,直觉和启发式方法被用来确定一个模型的哪些层如何与另一个模型的层结合。但可以看到,这个问题有一个组合上非常大的搜索空间,最适合由进化这样的优化算法来搜索。以下是这种方法的一个例子:

在参数空间(权重)中合并模型

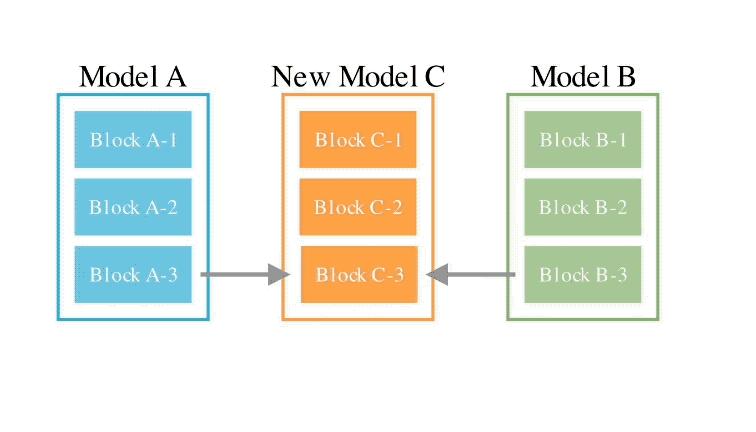

第二种方法是进化出混合多个模型权重的新方法。有无数种方法可以混合不同模型的权重以形成一个新模型,并且每一层的混合都可以原则上使用不同的混合比例。这就是进化方法可以有效地找到新的混合策略来组合多个模型的权重的地方。

以下是混合两个不同模型权重的示意图:

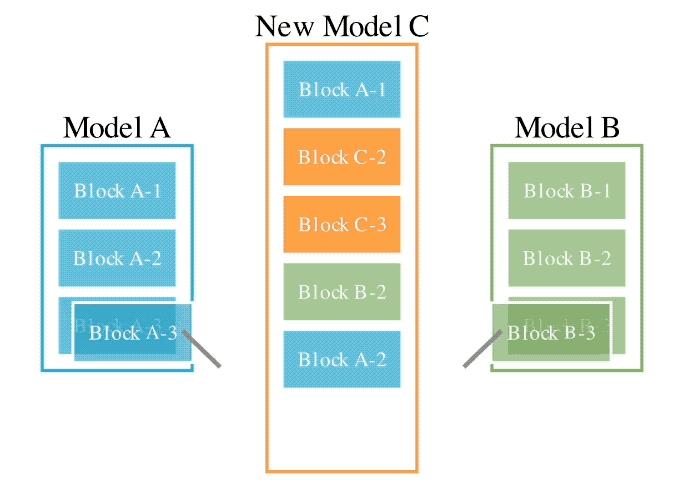

数据流空间和参数空间的方法也可以结合在一起,以进化出可能需要特定架构创新才能被进化发现的新基础模型:

在数据流空间和参数空间中合并模型

用以上进化模型合并方法,Sakana.ai推出了3个基础模型:

- 大型语言模型 (EvoLLM-JP)

- 视觉语言模型 (EvoVLM-JP)

- 图像生成模型 (EvoSDXL-JP)

EvoLLM-JP

此模型由日语大模型Shisa-Gamma和数学大模型WizardMath/Abel合并,擅长解决日语数学问题,进化了100-150代。

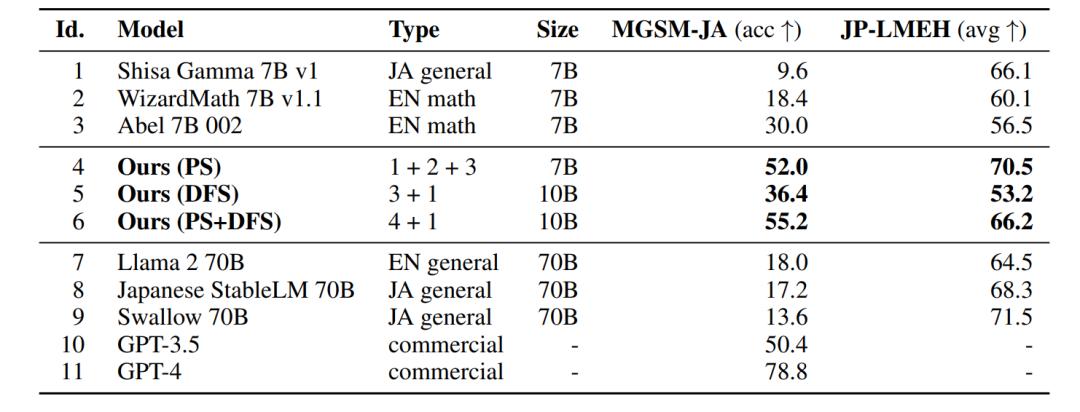

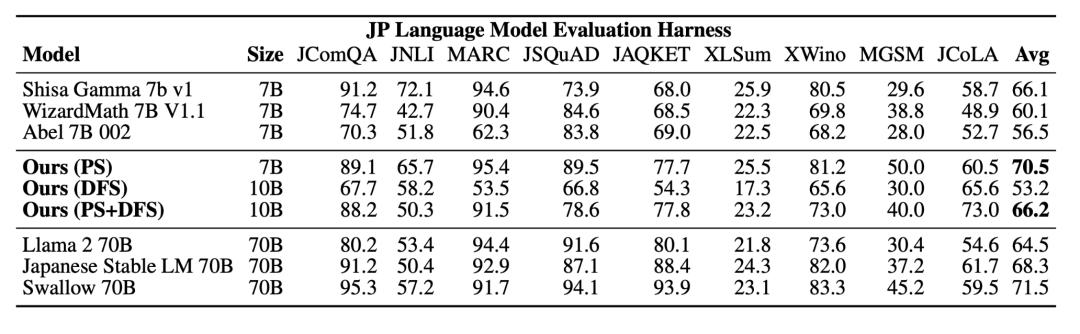

Sakana.ai使用了MGSM 数据集的日语评估集上正确响应的百分比,该数据集是著名的GSM8K数据集的多语言版本。

用日语解决数学问题的表现比较模型能力,MGSM-JA列显示正确答案的百分比。模型1-3为原始模型,模型4-6为优化合并模型。型号7-10是现有高性能LLM的分数。可以看到,合并后的模型性能,不仅高于合并前的模型,而且也部分超越了参数几乎是其十倍的Llama2 70B,但是与GPT-4相比,仍有明显差距。

此外,Sakana.ai也评估了一般日语能力。令人惊讶的是,这些模型在几项与数学无关的任务上也取得了高分,而且他们没有经过针对性的优化。

EvoVLM-JP

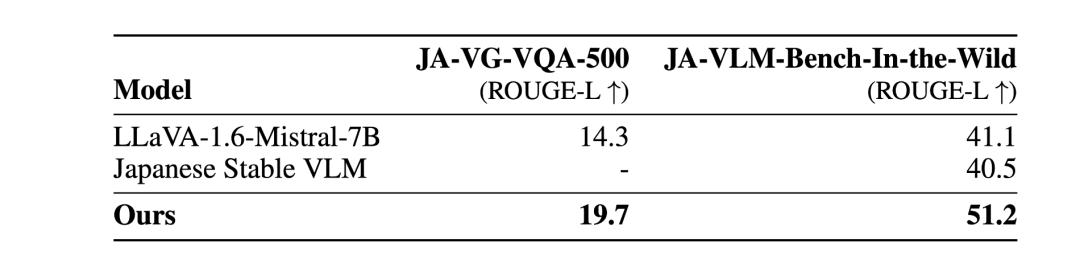

这个大模型由日语大模型Shisa Gamma 7B v1和LLaVa-1.6-Mistral-7B合并形成,是具有日语能力的VLM。

这是合并VLM和LLM的第一次尝试,Sakana.ai证明了进化算法可以在合并的成功中发挥重要作用。以下是评估结果:

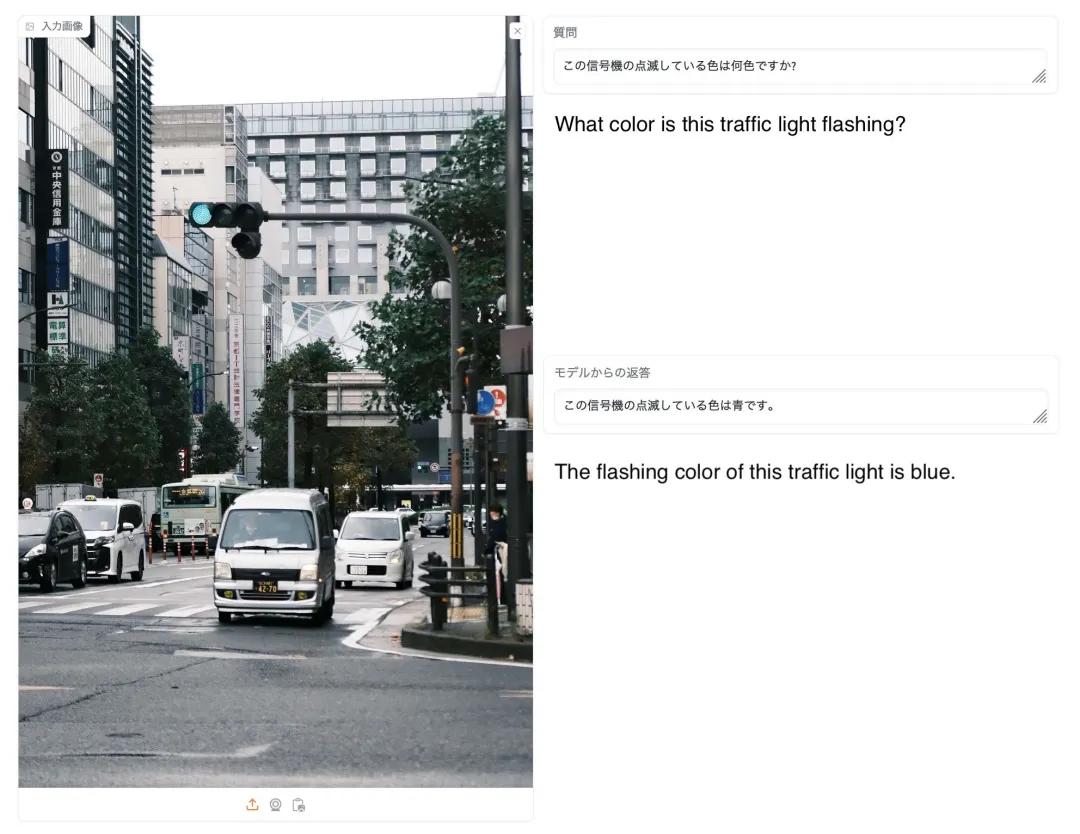

这个VLM模型,还可以理解图片内容,根据人类提示解析图片。

EvoSDXL-JP

这是一个支持日语的SDXL扩散模型。

进化算法也可以自动发现合并不同扩散模型的方法,而且这个模型也支持日语的提示,它模型经过优化,只需四个推理步骤即可执行推理,从而使生成速度极快。

以下是一些示例:

原则上,可以采用基于梯度的反向传播来进一步提高性能,但是此次Sakana.ai使用进化模型合并方法产生的模型没有经过任何基于梯度的训练,因此只需相对较少的计算资源。

这证明了即使没有反向传播,仍然可以进化出最先进的基础模型,挑战当前昂贵的模型开发范式。

新的模型合并方法使中外创业公司受惠

Sakana.ai预计AI将有一个新的趋势:通过组合现有的模型进化出具有特定能力的新模型。相比现在预训练新模型需要的庞大算力和能源成本,这样的创新十分有价值。

英伟达人工智能的负责人Jim Fan对Sakana.ai的技术评价:这是我最近读到的最具想象力的大模型论文之一,利用进化来合并HuggingFace中的开源模型,从而解锁新的能力。这是一种复杂的模型手术,但它所需的计算量比传统的大模型训练小得多。

目前,Sakana.ai还没有披露明确的商业计划,但是它的技术对于AI的应用创新和发展具有积极的意义。

创业公司可以利用开源社区的优质开源模型,通过这个技术生成符合自己产品和业务需求的特化模型,而无需负担预训练模型和微调模型的计算成本。尽管他们也能使用商业化的闭源模型打造应用,但这不仅需要付出较高的成本,而且推理成本也不低。闭源模型通常参数量较大,这不仅使推理变慢,而且很多垂直的创业公司也用不到这种通用模型的全部性能。

对于中国的创业者,这项技术也一样是福音,它使中国创业者能够低成本的调教和重组开源模型,一定程度上打破了因算力差距(封锁)造成的模型能力和迭代速度差距。而在打造应用的能力上,中国的创业者和产品经理们一向是世界领先,创意无穷的。这拉平了中外创业者的竞争优势。

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表本站立场。